« Kappa de Cohen » : différence entre les versions

Aucun résumé des modifications |

Aucun résumé des modifications |

||

| Ligne 9 : | Ligne 9 : | ||

En statistique, le test du κ (kappa) mesure l’accord entre observateurs lors d'un codage qualitatif en catégories. | En statistique, le test du κ (kappa) mesure l’accord entre observateurs lors d'un codage qualitatif en catégories. | ||

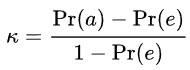

Le calcul du κ se fait de la manière suivante : | Le calcul du κ se fait de la manière suivante :<br /> | ||

[[ | [[Fichier:Kappa_de_cohen.jpg]] | ||

Où Pr(a) est l'accord relatif entre codeurs et Pr(e) la probabilité d'un accord aléatoire. Si les codeurs sont totalement en accord, κ = 1. S'ils sont totalement en désaccord (ou en accord dû uniquement au hasard), κ ≤ 0. | Où Pr(a) est l'accord relatif entre codeurs et Pr(e) la probabilité d'un accord aléatoire. Si les codeurs sont totalement en accord, κ = 1. S'ils sont totalement en désaccord (ou en accord dû uniquement au hasard), κ ≤ 0. | ||

Version du 5 janvier 2019 à 21:44

Domaine

Vocabulaire

Définition

En statistique, le test du κ (kappa) mesure l’accord entre observateurs lors d'un codage qualitatif en catégories.

Le calcul du κ se fait de la manière suivante :

Où Pr(a) est l'accord relatif entre codeurs et Pr(e) la probabilité d'un accord aléatoire. Si les codeurs sont totalement en accord, κ = 1. S'ils sont totalement en désaccord (ou en accord dû uniquement au hasard), κ ≤ 0.

Le κ est une mesure d'accord entre deux codeurs seulement. Pour une mesure de l'accord entre plus de deux codeurs, on utilise le κ de Fleiss (1981).

Français

Kappa de Cohen

Anglais

Cohen's kappa

Source: Wikipédia IA

Publié : datafranca.org

Contributeurs: wiki, Robert Meloche